Nvidiaの主力AIチップは、以前のチャンピオンよりも4.5倍高速

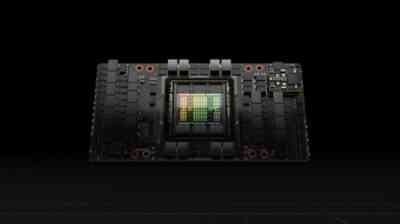

Nvidiaは昨日、今後のH100 “Hopper” Tensor Core GPU が、業界標準のMLPerfベンチマークでパフォーマンス記録を打ち立て、現在Nvidiaの最速のプロダクションAIチップであるA100よりも最大 4.5 倍速い結果を出したことを発表しました。

MPerf ベンチマーク (技術的には ” MLPerfTM Inference 2.1 ” と呼ばれます) は、”推論” ワークロードを測定します。これは、チップが以前にトレーニングされた機械学習モデルを新しいデータにどれだけうまく適用できるかを示します。

MLCommonsとして知られる業界企業のグループは、2018 年にMLPerf ベンチマークを開発し、機械学習のパフォーマンスを潜在的な顧客に伝えるための標準化された指標を提供しました。

特に、H100は、Googleが開発したBERTモデルを使用して自然言語処理のパフォーマンスを測定するBERT-Largeベンチマークで好成績を収めました。Nvidiaは、この特定の結果を、HopperアーキテクチャTransformer Engineのおかげであると考えています。

これは特に、Transformerモデルのトレーニングを高速化します。これは、H100 がOpenAIのGPT-3に似た将来の自然言語モデルを加速できることを意味します。GPT-3は、さまざまなスタイルで書かれた作品を作成し、会話型チャットを行うことができます。

Nvidiaは、H100 を、画像認識、大規模言語モデル、画像合成などの AI およびスーパーコンピューター アプリケーション用に設計されたハイエンド データセンター GPUチップとして位置づけています。アナリストは、Nvidia の主力データセンター GPU としてA100に取って代わると予想していますが、まだ開発中です。先週、中国へのチップの輸出に米国政府が課した制限により、開発の一部が中国で行われているため、Nvidiaが2022 年末までに H100 を提供できない可能性があるという懸念が生じました。

Nvidiaは先週、証券取引委員会への2 回目の提出書類で、米国政府が中国でのH100の継続的な開発を許可することを明らかにしたため、プロジェクトは今のところ順調に戻っているようです。Nvidiaによると、H100は「今年後半」に発売される予定です。前世代のA100チップの成功が何らかの兆候である場合、H100 は、今後数年間で多種多様な画期的な AI アプリケーションを強化する可能性があります。

(via Arts Technica)

Last Updated on 2022年9月10日 by Editor