Apple、マシンラーニングの公式ページで「Hey Siri」のメカニズムを紹介

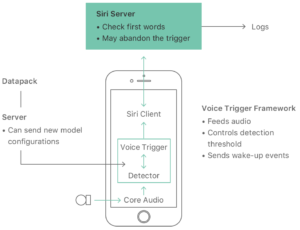

Appleの「Machine Learning Journal」には、最新のiPhoneとiPad Proモデルで、ハンズフリーの「Hey Siri」機能にどのようにハードウェア、ソフトウェア、およびインターネットサービスが連携して機能するかを説明しています。

具体的には、埋め込まれたモーションコプロセッサに内蔵された非常に小さな音声認識装置が常に動作し、「Hey Siri」を感知します。「Hey Siri」が検出されると、Siriは後続の音声をコマンドまたはクエリとして解析します。

検出器は、ディープニューラルネットワークを使用して、ユーザーの音声の音響パターンを確率分布に変換すします。次に時間積分プロセスを使用して、発声されたフレーズが「Hey Siri」であるという信頼スコアを計算します。

スコアが十分に高い場合、Siriは起動してコマンドを完了するか、クエリに自動的に応答します。

しかし、スコアがAppleの下限しきい値を超えて、上限しきい値を超えていない場合、デバイスは数秒間より敏感な状態になり、ユーザがそれ以上の努力をしなくてもフレーズを繰り返すと、Siriが呼び出される可能性が高くなります。

また、「Hey Siri」では他人の間違った利用を減らすために、Appleはユーザーに「Hey Siri」で始まる5つのフレーズがある短い登録セッションを完了するようにユーザーを案内します。音声データはデバイスに保存されます。

登録時に作成された参照パターンとの距離を別のしきい値と比較して、検出器をトリガーした音が登録ユーザーが話した「Hey Siri」である可能性が高いかどうかを判断します。

このプロセスは、他の人が話す “Hey Siri”がiPhoneを起動させる確率を下げるだけでなく、他の類似した発音のフレーズがSiriをトリガーする割合を減らします。

Appleはまた、世界中の多くの言語のネイティブスピーカーに基づいて、台所、車、寝室、レストランなどのさまざまな環境で「Hey Siri」レコーディングを作成したと語っています。

さらに詳しく知りたい方は、Appleの「Machine Learning Journal」のページをご覧ください。

(via MacRumors)

Last Updated on 2017年10月19日 by Editor